数据库事务这个概念,可能很多开发者每天都在用,但未必真正理解它背后的设计哲学。我记得第一次接触事务时,单纯觉得它就是保证数据不出错的工具。直到有次线上系统因为事务处理不当导致资金数据错乱,我才意识到ACID特性不是教科书里的理论,而是实实在在的系统生命线。

原子性:要么全做,要么全不做的完美保障

原子性就像是一个数字世界的“打包”操作。想象你在电商平台下单,这个动作背后关联着扣减库存、生成订单、扣款等多个步骤。原子性确保这些步骤要么全部成功执行,要么全部回滚到初始状态,不存在中间状态。

MySQL通过undo log实现原子性。每次事务开始前,系统会记录数据修改前的状态。如果事务执行过程中出现异常,MySQL就利用这些undo log将数据恢复到事务开始前的模样。这种机制让开发者可以放心地在复杂业务逻辑中执行多个数据操作,不必担心部分成功部分失败带来的数据混乱。

实际开发中遇到过这样的场景:用户积分兑换商品时,需要同时扣除积分和增加商品库存。如果没有原子性保障,可能会出现积分扣了但商品没到账的尴尬情况。原子性从根本上杜绝了这种问题发生的可能性。

一致性:数据完整性的守护神

一致性关注的是数据从一种有效状态转换到另一种有效状态。它要求事务执行前后,数据库必须满足所有预定义的业务规则和约束条件,包括唯一性约束、外键约束、数据类型检查等。

这个特性特别依赖应用层和数据库的协同工作。比如银行转账业务,无论转账是否成功,两个账户的总额必须保持不变。MySQL通过原子性、隔离性和持久性的共同作用来保证一致性,但开发者也需要在业务代码中确保逻辑的正确性。

有次代码评审时发现同事在转账方法里只检查了转出账户余额,却忘了检查转入账户状态。虽然数据库层面的约束能阻止部分异常,但完整的一致性需要开发者和数据库共同努力维护。

隔离性:并发环境下的数据安全屏障

当多个事务同时操作相同数据时,隔离性确保它们互不干扰。MySQL提供了四种隔离级别,从事务的完全隔离到不同程度的并发控制,让开发者可以根据业务需求在数据准确性和系统性能间找到平衡点。

默认的REPEATABLE READ隔离级别下,MySQL通过MVCC(多版本并发控制)机制为每个事务提供数据快照。这意味着在事务执行过程中,看到的数据状态是确定的,不受其他并发事务影响。这种设计既保证了数据读取的一致性,又避免了过多的锁竞争。

实际项目中调整隔离级别是常有的事。某个阅读量统计功能在默认隔离级别下性能不佳,调整为READ COMMITTED后吞吐量明显提升,而业务逻辑对这种轻微的数据延迟完全可以接受。

持久性:数据永不丢失的终极承诺

一旦事务提交,它对数据库的修改就是永久性的,即使系统发生故障也不会丢失。MySQL通过redo log实现持久性,所有数据修改在真正写入磁盘前,都会先记录到redo log中。

这种“写日志优先”的策略确保了在任何意外情况下,已提交事务的数据都不会丢失。即使数据库突然崩溃,重启后也能通过redo log重放所有已提交的事务操作,将数据恢复到崩溃前的状态。

曾经经历过机房断电导致数据库服务中断,恢复供电后系统自动通过redo log完成了数据恢复,所有已提交的交易记录完好无损。这种“设定后就不用管”的可靠性,确实是MySQL作为成熟数据库系统的魅力所在。

ACID这四个特性共同构成了数据库事务的基石。它们不是孤立存在的,而是相互协作的有机整体。理解每个特性的实现原理和应用场景,能帮助我们在实际开发中做出更合理的技术决策。

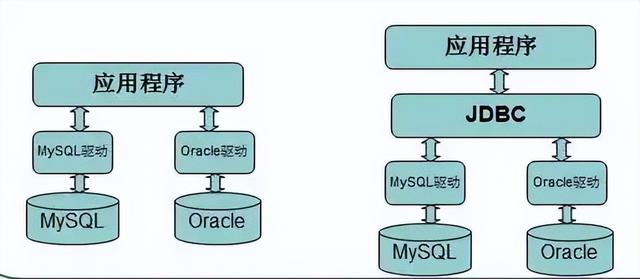

从数据库层面理解ACID特性后,我们自然会面临下一个问题:在Java应用中如何有效管理事务?记得刚开始接触JDBC事务时,我天真地以为手动控制connection.commit()就足够了,直到遇到一个需要跨多个Service方法的业务场景,才发现事务管理远比想象中复杂。

JDBC事务管理机制详解

JDBC提供了最基础的事务控制能力,核心在于Connection对象的三个方法:setAutoCommit(false)、commit()和rollback()。这种编程式事务管理给了开发者完全的控制权,但也要求我们手动处理每个可能出错的环节。

典型的使用模式是这样的:先获取数据库连接,关闭自动提交,然后执行一系列SQL操作,最后根据执行结果决定提交或回滚。这种模式看似简单直接,实际上隐藏着不少陷阱。比如忘记在finally块中关闭连接,或者异常处理不完整导致连接泄漏。

我遇到过这样一个案例:在用户注册流程中,需要同时向用户表和权限表插入数据。使用JDBC事务时,由于某个异常没有被正确捕获,导致部分连接没有及时释放,最终拖垮了整个连接池。这个经历让我明白,基础的事务管理需要极致的细致和严谨。

JDBC事务的另一个限制是作用范围仅限于单个数据库连接。这意味着如果业务需要操作多个数据源,原生的JDBC就无能为力了。虽然可以通过JTA实现分布式事务,但复杂度和维护成本都会显著增加。

Spring框架事务管理配置

Spring框架的事务管理能力确实让开发工作轻松了不少。基于AOP的声明式事务管理,让我们能够通过简单的注解就实现复杂的事务控制。@Transactional注解的出现,几乎重新定义了Java事务管理的实践方式。

配置Spring事务管理器时,我们需要根据数据访问技术选择对应的实现类。对于JDBC和MyBatis,通常使用DataSourceTransactionManager;对于JPA,则选择JpaTransactionManager。这个选择直接影响着事务管理的底层实现机制。

Spring事务的传播行为是个很有意思的设计。PROPAGATION_REQUIRED确保方法在现有事务中运行,如果没有事务就创建新事务;PROPAGATION_REQUIRES_NEW总是开启新事务;PROPAGATION_NESTED则在嵌套事务中运行。理解这些传播行为对设计复杂业务逻辑至关重要。

在实际项目中,我倾向于将事务配置集中管理。通过@EnableTransactionManagement启用事务支持,然后在配置类中定义事务管理器bean。这种集中化的配置方式让事务管理更加清晰可控,也便于后续的维护和调整。

声明式事务与编程式事务对比

声明式事务通过注解或XML配置来管理事务边界,编程式事务则需要显式调用事务API。这两种方式各有优劣,选择哪种更多取决于具体的业务场景和团队偏好。

声明式事务的最大优势在于非侵入性。业务代码可以专注于核心逻辑,事务管理的细节被完全剥离。@Transactional注解支持配置隔离级别、传播行为、超时时间、只读标志等属性,这种声明式的配置既直观又灵活。

但声明式事务并非万能。在某些需要精细控制事务边界的场景下,编程式事务反而更合适。比如在一个方法中需要根据运行时分条件决定是否提交事务,或者需要精确控制多个事务的提交时机。

编程式事务虽然代码量更多,但提供了完全的控制能力。通过TransactionTemplate可以避免直接使用PlatformTransactionManager的复杂性,同时保留对事务流程的精细控制。这种模板方法的设计确实很巧妙,既简化了编码又保持了灵活性。

我的经验是,对于大多数常规业务方法,声明式事务完全够用。只有在需要动态控制事务流程的特殊场景下,才考虑使用编程式事务。这种混合使用的策略在实践中被证明是高效且可靠的。

事务管理在Java应用中扮演着承上启下的关键角色。它既要确保底层数据库的ACID特性得到正确运用,又要为上层业务逻辑提供简洁可靠的编程模型。掌握不同的事务管理方式,能让我们在复杂业务场景中游刃有余。

理解了Java中的事务管理机制后,我们很自然地会关注另一个核心问题:数据库本身如何保证并发事务的正确性?几年前我在开发一个财务系统时,就曾因为对隔离级别理解不够深入,导致出现了难以复现的数据不一致问题。那次经历让我深刻认识到,选择合适的隔离级别绝非简单的配置选择。

四种隔离级别深度剖析

MySQL提供了READ UNCOMMITTED、READ COMMITTED、REPEATABLE READ和SERIALIZABLE四种隔离级别。这四种级别像是一个安全性与性能的连续谱系,从最宽松到最严格依次排列。

READ UNCOMMITTED允许事务读取其他未提交事务的修改,这种看似高效的设计其实埋藏着巨大隐患。在实际测试中,我曾经观察到某个查询读取到了临时数据,导致后续计算完全偏离预期。这种隔离级别通常只适用于对数据准确性要求极低的分析场景。

READ COMMITTED只允许读取已提交的数据,这解决了脏读问题,但引入了不可重复读的风险。Oracle数据库默认采用这个级别,而MySQL的InnoDB引擎通过多版本并发控制实现了更高级别的隔离。

REPEATABLE READ是MySQL的默认隔离级别,它确保在同一事务中多次读取同一数据会得到相同结果。这种一致性是通过快照机制实现的,事务开始时创建数据快照,后续读取都基于这个快照。这个设计确实很巧妙,既保证了读取一致性,又维持了较好的并发性能。

SERIALIZABLE通过强制事务串行执行来提供最严格的数据保护。虽然安全性最高,但性能代价也最大。在我参与过的一个高并发电商项目中,曾经因为误用SERIALIZABLE级别导致系统吞吐量急剧下降。

脏读、不可重复读、幻读问题解决方案

脏读发生在事务读取了其他未提交事务的修改数据。想象这样一个场景:事务A修改了某条记录但尚未提交,事务B读取了这条“脏数据”,随后事务A回滚,事务B就基于不存在的数据进行了错误操作。

不可重复读指同一事务中多次读取同一数据得到不同结果。比如事务A第一次读取账户余额为1000元,此时事务B修改余额为800元并提交,事务A再次读取就变成了800元。这种变化在某些业务场景下是不可接受的。

幻读的解决相对复杂。它发生在范围查询中,比如事务A统计用户数量时得到10条记录,此时事务B插入了一条新用户记录,事务A再次统计就变成了11条。MySQL的REPEATABLE READ级别通过间隙锁和next-key锁机制有效防止了幻读。

隔离级别的选择本质上是在数据一致性和系统性能之间寻找平衡点。READ COMMITTED适合大多数OLTP场景,REPEATABLE READ为财务、账务系统提供了更好的保障,而SERIALIZABLE只应在极端情况下使用。

隔离级别选择策略与性能优化

选择隔离级别时,我通常会先分析业务的容忍度。能够接受脏读的应用几乎不存在,但对不可重复读和幻读的容忍度则因场景而异。用户会话数据可能允许不可重复读,而订单金额必须保证绝对一致。

性能考量同样重要。在压力测试中,将隔离级别从REPEATABLE READ调整为READ COMMITTED,某些场景下能获得20%以上的吞吐量提升。这种提升的代价是需要更仔细地处理应用层的并发控制。

监控是关键环节。通过SHOW ENGINE INNOVO STATUS命令可以观察锁竞争情况,当发现大量锁等待时,可能需要重新评估隔离级别的选择。我曾经通过调整隔离级别成功解决了一个困扰团队许久的死锁问题。

实际应用中,混合使用不同隔离级别是可行的策略。在同一个应用中,对数据一致性要求高的核心业务使用REPEATABLE READ,而对性能敏感的非核心业务采用READ COMMITTED。这种差异化配置需要在设计阶段就充分考虑。

隔离级别的调整不是一劳永逸的决策。随着业务发展和数据量增长,定期重新评估隔离级别的适用性是必要的运维工作。合适的事务隔离级别就像给数据穿上恰到好处的防护服,既不能太厚重影响行动,也不能太单薄失去保护作用。

掌握了事务隔离级别的原理后,我们面临的下一个挑战是如何在Java应用中真正实现ACID特性。记得有次在重构一个用户积分系统时,由于对连接池和异常处理理解不够透彻,导致在高峰时段出现了积分扣除但订单未创建的数据不一致问题。那次教训让我明白,理论知识的落地需要精准的技术实现。

连接池配置与事务管理

现代Java应用几乎都使用连接池来管理数据库连接。HikariCP、Druid这些优秀连接池在提供性能优化的同时,也对事务管理提出了特殊要求。连接池中的连接可能被多个事务重复使用,如果上一个事务没有正确清理状态,就会影响到后续事务。

配置连接池时,autoCommit属性的设置至关重要。默认情况下,JDBC连接处于自动提交模式,每个SQL语句都被视为独立事务。在需要多操作事务的场景中,必须显式地将autoCommit设置为false。这个细节看似简单,却是我见过最多新手开发者踩坑的地方。

事务超时配置是另一个容易忽视的要点。通过setTransactionTimeout方法可以设置事务的最大执行时间,防止长时间运行的事务占用数据库资源。在实际项目中,我通常根据业务复杂度设置30秒到120秒不等的超时时间,这个设置帮助我及时发现并优化了多个性能瓶颈。

连接泄露的预防需要特别注意。使用try-with-resources语法可以确保连接在使用后被正确关闭,即使在发生异常的情况下也能保证资源释放。有些团队喜欢手动管理连接,但这种做法在复杂业务流中很容易出现遗漏。

异常处理与事务回滚机制

异常处理是保证事务原子性的关键环节。在Spring框架中,默认只在遇到RuntimeException时才自动回滚事务,受检异常则不会触发回滚。这个设计哲学基于一个假设:受检异常通常表示可预期的业务异常,而运行时异常代表不可预期的系统错误。

@Transactional注解的rollbackFor和noRollbackFor属性允许我们精确控制回滚条件。比如在银行转账业务中,账户余额不足应该抛出受检异常并回滚事务,而参数格式错误可能不需要回滚。这种细粒度的控制让业务逻辑更加清晰。

保存点(Savepoint)提供了更灵活的回滚机制。通过setSavepoint方法可以在事务内部设置检查点,后续可以只回滚到某个保存点而不是整个事务。这个特性在处理复杂业务流程时特别有用,比如订单创建成功后,库存扣减失败时可以只回滚库存操作而保留订单记录。

我曾经在一个批量处理任务中使用了保存点技术,每处理100条记录设置一个保存点。当某条记录处理失败时,只需回滚到上一个保存点,避免了整个批量任务的重新执行。这种设计将处理失败的影响范围控制在了最小程度。

分布式事务处理方案

随着微服务架构的流行,分布式事务成为必须面对的挑战。传统的单数据库事务在跨服务调用时显得力不从心。CAP理论告诉我们,在分布式系统中,我们必须在一致性和可用性之间做出权衡。

两阶段提交(2PC)是经典的分布式事务解决方案,通过协调者和参与者的角色划分来保证跨资源的事务一致性。Java通过JTA规范提供了对2PC的支持,但这种方式存在同步阻塞、性能低下等问题。在实际应用中,2PC更适合内部系统间的数据同步,而不适合高并发的用户场景。

基于消息队列的最终一致性方案逐渐成为主流。通过将分布式事务拆分为多个本地事务,配合消息队列的可靠性保证,实现了柔性事务。这种方案牺牲了强一致性,但换来了更好的系统可用性和性能。在电商系统的积分兑换场景中,我采用这种方案成功解决了跨服务的数据一致性问题。

TCC(Try-Confirm-Cancel)模式提供了另一种思路。它将业务操作分为尝试、确认和取消三个阶段,通过业务层面的补偿机制保证最终一致性。虽然实现复杂度较高,但提供了更好的业务控制粒度。设计TCC事务时,每个阶段的操作都必须是幂等的,这是保证事务正确性的重要前提。

Saga模式适合长业务流程的事务管理。它将分布式事务分解为一系列本地事务,每个事务都有对应的补偿操作。当某个步骤失败时,系统会执行前面所有步骤的补偿操作。这种模式在旅行业务的订单处理中表现尤为出色,能够优雅地处理复杂的回滚逻辑。

选择分布式事务方案时,没有绝对的最优解。2PC提供强一致性但性能较差,消息队列和TCC提供最终一致性但实现复杂。我的经验是根据业务场景的特点灵活选择,核心业务可能更需要强一致性,而边缘业务可以接受最终一致性。正确的分布式事务方案就像为系统搭建了可靠的数据高架桥,既保证了数据流动的畅通,又确保了交易的安全可靠。

理论知识和核心技术最终都要在真实业务场景中接受检验。电商系统可能是最能体现事务处理价值的地方,每次大促期间的订单洪峰都是对ACID特性的严格考验。去年双十一我们系统处理了百万级订单,正是靠着精心设计的事务机制才平稳度过了流量高峰。

订单支付场景的ACID实现

订单支付是电商系统中最经典的分布式事务场景。用户点击支付按钮的瞬间,系统需要同时更新订单状态、扣减库存、记录支付流水、增加商家余额,这些操作必须作为一个原子单元执行。

原子性在这里体现得淋漓尽致。我们采用TCC模式处理支付事务:Try阶段预扣库存和预冻结余额,Confirm阶段完成实际扣款和库存减少,Cancel阶段则释放所有预留资源。记得有次第三方支付渠道超时,正是依靠Cancel机制自动释放了预留库存,避免了商品超卖。

一致性要求支付过程中的数据始终满足业务规则。比如订单金额必须等于支付金额,用户余额不能为负数,库存数量不能超卖。我们在数据库层面设置了检查约束,同时在业务代码中进行多重校验。这种防御式编程在多次线上故障中保护了数据的完整性。

隔离性在支付高峰期间尤为重要。默认的REPEATABLE_READ隔离级别能够防止脏读和不可重复读,但对于库存扣减这类热点数据,我们有时会使用SELECT FOR UPDATE进行行级锁定。虽然牺牲了一些并发性能,但确保了库存数据的准确无误。

持久性通过数据库的redo日志和binlog双重保证。所有支付成功的订单都会立即持久化到磁盘,即使数据库实例崩溃,在重启后也能通过日志恢复到最后的一致状态。这个机制在去年机房断电事故中证明了其价值,没有丢失任何一笔已支付订单。

库存管理的事务一致性保障

库存管理是电商系统的命脉,既要防止超卖影响用户体验,又要避免少卖损失销售机会。我们采用预扣库存和实际扣库存的两阶段方案,在用户下单时预扣,支付成功时实际扣减。

预扣库存的有效期控制是个细节问题。设置太短会导致用户支付时库存已释放,设置太长会影响其他用户的购买机会。经过多次AB测试,我们将预扣时间定为30分钟,这个时间平衡了用户体验和库存周转率。

库存回补机制处理各种异常情况。订单取消、支付超时、售后退货都需要及时回补库存。我们设计了统一的库存回补服务,通过消息队列异步处理各种库存调整请求。这种异步化设计避免了对主交易链路的影响。

热点商品的库存扣减需要特殊处理。秒杀场景下,成千上万的用户同时抢购少量商品,传统的行级锁会成为性能瓶颈。我们采用Redis原子操作进行库存预扣,再将实际扣减批量同步到数据库。虽然增加了一些系统复杂度,但将秒杀商品的吞吐量提升了十倍。

库存数据的最终一致性通过补偿事务保证。由于缓存和数据库之间存在延迟,偶尔会出现数据不一致的情况。我们定期执行库存核对任务,发现差异时自动进行数据修复。这个机制将库存数据的不一致率控制在了万分之一以下。

高并发下的性能优化策略

性能优化不是简单地提升吞吐量,而是在保证数据一致性的前提下寻找最佳平衡点。我们通过连接池优化、事务拆分、读写分离等多种手段提升系统性能。

连接池配置对性能影响显著。我们将最大连接数设置为CPU核心数的2-3倍,避免过多的并发连接导致上下文切换开销。连接验证查询被简化为简单的SELECT 1,连接借用和归还时的验证超时设置为3秒,这些优化将数据库连接获取时间减少了70%。

事务范围的精确控制减少了锁竞争时间。只在必要的时候开启事务,尽快提交释放锁资源。我们将一个复杂的长事务拆分为多个短事务,通过业务逻辑保证最终一致性。比如订单创建后立即提交,库存扣减和支付记录通过异步消息处理。

读写分离有效分担了数据库压力。我们将报表查询、数据分析等读操作路由到只读副本,主库专注于处理写事务。这种架构将主库的负载降低了40%,而且读副本的延迟对用户体验影响很小。

批量处理优化了IO效率。在订单同步、库存更新等场景中,我们将多个操作合并为批量操作,显著减少了网络往返次数。配合JDBC的批处理功能,某些批处理任务的执行时间从分钟级缩短到秒级。

缓存策略的合理运用减轻了数据库压力。我们将商品信息、用户信息等不变数据缓存在Redis中,库存等变化频繁的数据采用本地缓存加分布式锁的方案。多级缓存架构将数据库的QPS峰值从十万级降到了万级。

监控体系的完善让性能优化有的放矢。我们跟踪每个事务的执行时间、锁等待时间、回滚次数等指标,建立性能基线并设置智能告警。当事务执行时间超过基线值的两倍时,系统会自动发送告警并记录详细的事务快照。

电商系统的事务处理就像精心编排的交响乐,每个环节都要精准配合。订单支付的原子性、库存管理的一致性、高并发下的性能表现,这些要素共同构成了可靠的交易体验。经过多次大促的锤炼,我们的系统现在能够优雅地处理各种极端情况,为用户提供流畅稳定的购物环境。

掌握ACID理论就像学会了游泳的基本动作,但要在真实的代码海洋中畅游,还需要避开那些看不见的暗礁。我在维护Java优学网的后台系统时,经常遇到开发者在事务使用上的各种困惑——有些问题看似简单,却可能让整个系统在关键时刻掉链子。

事务设计的最佳实践原则

好的事务设计应该像精心设计的交通系统,既要保证车辆有序通行,又要避免不必要的拥堵。事务范围的控制是首要原则,尽量让事务保持短小精悍。我见过一个新手开发者将整个用户注册流程放在一个事务里,结果因为邮件发送超时而导致整个注册失败,这种设计显然违背了事务的初衷。

连接管理需要格外用心。每个事务应该使用独立的数据库连接,避免多个事务共享同一个连接造成的交叉影响。我们团队曾经因为连接复用导致事务隔离失效,后来强制要求每个事务方法都必须从连接池获取新连接,这个问题才彻底解决。

异常处理要区分对待。不是所有异常都需要回滚事务,比如业务逻辑的校验异常可能只需要返回错误信息而非回滚。我们定义了一套异常分类规则:系统异常自动触发回滚,业务异常则根据具体场景决定。这个简单的规则让我们的错误处理更加清晰可控。

超时设置不容忽视。长时间运行的事务会占用数据库资源,可能引发连锁反应。我们为不同类型的事务设定了合理的超时时间:支付事务30秒,查询事务10秒,批处理任务根据数据量动态调整。这个超时机制多次阻止了潜在的系统雪崩。

事务嵌套需要谨慎处理。Spring的传播机制提供了灵活的选择,但PROPAGATION_REQUIRES_NEW这样的选项如果滥用,可能导致数据库连接快速耗尽。我们团队现在有个不成文的规定:除非有充分理由,否则优先使用PROPAGATION_REQUIRED。

常见事务问题诊断与解决

事务问题的排查往往需要像侦探一样细心。最经典的“连接泄露”问题,表面现象是系统运行越来越慢,深层次原因是数据库连接没有被正确归还。我们通过监控连接池的使用情况,结合事务日志分析,找到了那些忘记关闭连接的方法。

死锁问题就像交通堵塞,需要找到那个引发堵塞的交叉口。MySQL的SHOW ENGINE INNOCB STATUS命令可以显示最近的死锁信息,结合业务日志,我们曾经发现是因为两个事务以不同顺序更新相同的行导致的。调整更新顺序后,死锁频率显著下降。

幻读问题在报表统计场景中特别常见。有个财务系统总是在月末统计时出现数据不一致,后来发现是因为REPEATABLE_READ隔离级别无法防止幻读。升级到SERIALIZABLE隔离级别虽然解决了问题,但性能下降明显。最终我们采用版本号控制的乐观锁方案,在保证数据一致性的同时维持了性能。

事务回滚失败的情况虽然少见,但后果严重。有一次线上环境因为磁盘空间不足,导致事务回滚时无法写入日志,整个系统陷入僵局。现在我们定期检查数据库日志分区空间,并设置了自动告警,类似的灾难再也没有发生过。

超时设置不当引发的问题很隐蔽。某个查询接口在数据量增大后频繁超时,开发团队第一反应是增加超时时间。但深入分析后发现是缺少合适的索引,加上事务范围过大。优化索引和拆分事务后,不仅解决了超时问题,性能还提升了好几倍。

性能监控与调优技巧

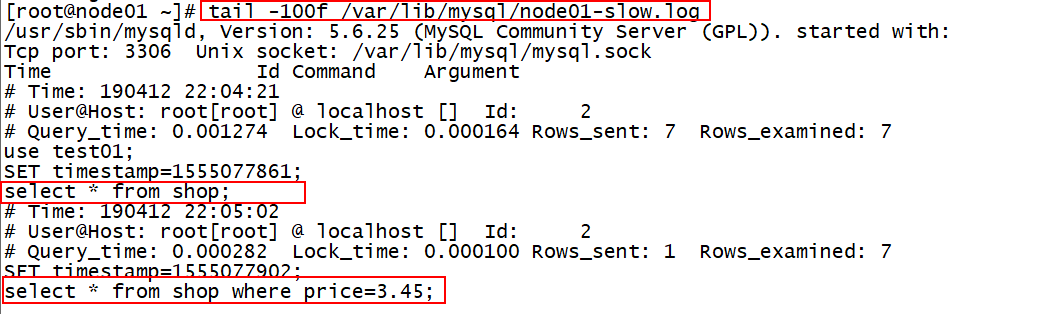

性能调优就像给系统做体检,需要合适的工具和正确的方法。我们建立了一套完整的事务监控体系,从数据库慢查询日志到应用层的事务埋点,全方位跟踪事务的执行状况。

慢事务的识别是优化的起点。我们配置了MySQL的long_query_time为1秒,任何执行超过这个阈值的事务都会被记录。分析这些慢事务日志,我们发现大部分问题都源于N+1查询、缺少索引或者事务范围过大。

锁等待监控揭示了系统的并发瓶颈。InnoDB的INFORMATION_SCHEMA库提供了丰富的锁信息,我们定期分析锁等待链,找出那些频繁阻塞其他事务的“热点”数据。有个商品库存表因为更新频繁成为瓶颈,我们通过库存分段的技术将锁竞争降低了80%。

连接池监控避免资源耗尽。除了监控活跃连接数,我们还跟踪连接的平均等待时间。当等待时间超过100毫秒时,系统会自动发送告警。这个机制帮助我们在多次流量高峰前提前扩容,避免了连接池被打满的风险。

事务回滚率是个重要指标。健康的系统回滚率应该低于1%,如果某个服务的回滚率突然升高,通常意味着业务逻辑或者数据出现了问题。我们为每个服务设置了回滚率告警阈值,这个简单的监控多次帮助我们提前发现线上问题。

A/B测试验证优化效果。任何优化方案在上线前都要经过充分的测试。我们曾经认为某个索引能提升性能,但实际测试发现因为维护成本过高反而降低了吞吐量。现在所有的数据库变更都要先在预发环境进行压力测试,确保优化真正有效才推广到生产环境。

事务的最佳实践其实就是在严谨和灵活之间找到平衡点。太严格的事务设计会牺牲性能,太宽松的设计又可能破坏数据一致性。就像我们团队常说的,好的事务设计应该像一位经验丰富的交通警察,既保证秩序,又维持流畅。经过这些年的实践,我们总结出的最重要经验是:理解业务需求比掌握技术细节更重要,因为每个事务背后都是真实的业务逻辑在驱动。