微服务架构正在重塑现代软件开发模式。Java优学网作为技术学习平台,采用SpringCloud构建的分布式系统面临着复杂的服务调用关系。当用户点击一个课程视频时,这个简单操作背后可能涉及用户服务、课程服务、支付服务、推荐服务等十余个微服务的协同工作。

SpringCloud分布式系统监控的重要性

在单体应用时代,排查问题相对直接。所有功能模块运行在同一个进程中,日志集中存储,调用栈清晰可见。微服务架构打破了这种便利性。每个服务独立部署,拥有自己的数据库和日志系统。一个请求需要穿越多个服务节点,就像在迷宫中寻找出口。

我记得去年参与的一个电商项目,用户反馈订单状态更新延迟。我们花了三天时间才定位到问题根源——商品服务与库存服务间的异步通信超时。如果当时有完善的链路追踪系统,这个问题可能在十分钟内就能解决。

分布式系统监控不再是可有可无的装饰品,而是保障系统稳定性的必需品。它提供了观察系统内部运行状态的窗口,让开发团队能够快速理解服务间的依赖关系,及时发现问题瓶颈。

Java优学网平台的技术架构特点

Java优学网采用典型的SpringCloud微服务架构。整个平台被拆分为用户中心、课程管理、学习进度、内容推荐、支付网关等核心服务模块。每个服务都使用SpringBoot框架开发,通过Eureka实现服务注册与发现,Feign处理服务间调用,Zuul网关负责请求路由。

这种架构带来了明显的优势。各个团队可以独立开发部署负责的微服务,技术栈选择更加灵活,系统扩展性显著提升。但硬币总有另一面,服务拆分也引入了新的复杂性。

平台高峰期同时在线学习用户超过五万,每天产生数百万次服务调用。某个课程页面的加载可能需要调用六个不同的微服务。没有链路追踪工具,我们就像在黑暗中摸索,无法看清完整的请求路径。

链路追踪在微服务架构中的核心价值

链路追踪技术为分布式系统提供了“X光透视”能力。它能够记录单个请求在系统中的完整执行路径,包括经过的每个服务节点、调用的方法、执行时间等关键信息。这不仅仅是技术层面的改进,更是开发运维理念的革新。

在实际应用中,链路追踪帮助我们发现了许多隐藏的性能问题。比如某个SQL查询在单独测试时性能良好,但在完整调用链中却成为瓶颈。或者某个第三方接口的偶尔超时,会级联影响整个系统的响应速度。

对于Java优学网这样的技术教育平台,稳定的用户体验至关重要。学员在进行在线编程练习时,任何系统延迟都可能打断学习思路。链路追踪让我们能够提前发现潜在风险,在用户感知到问题之前就完成优化。

微服务架构就像交响乐团,每个乐手(服务)都需要精准配合。链路追踪就是那位指挥家,确保整个演出和谐有序。

SpringCloud链路追踪的实现就像给分布式系统装上了GPS导航。当请求在微服务网络中穿梭时,这个系统能够精确记录它的每一个足迹。想象一下,在Java优学网中,用户点击“开始学习”按钮的瞬间,一个完整的调用旅程就此展开。

SpringCloud链路追踪技术架构

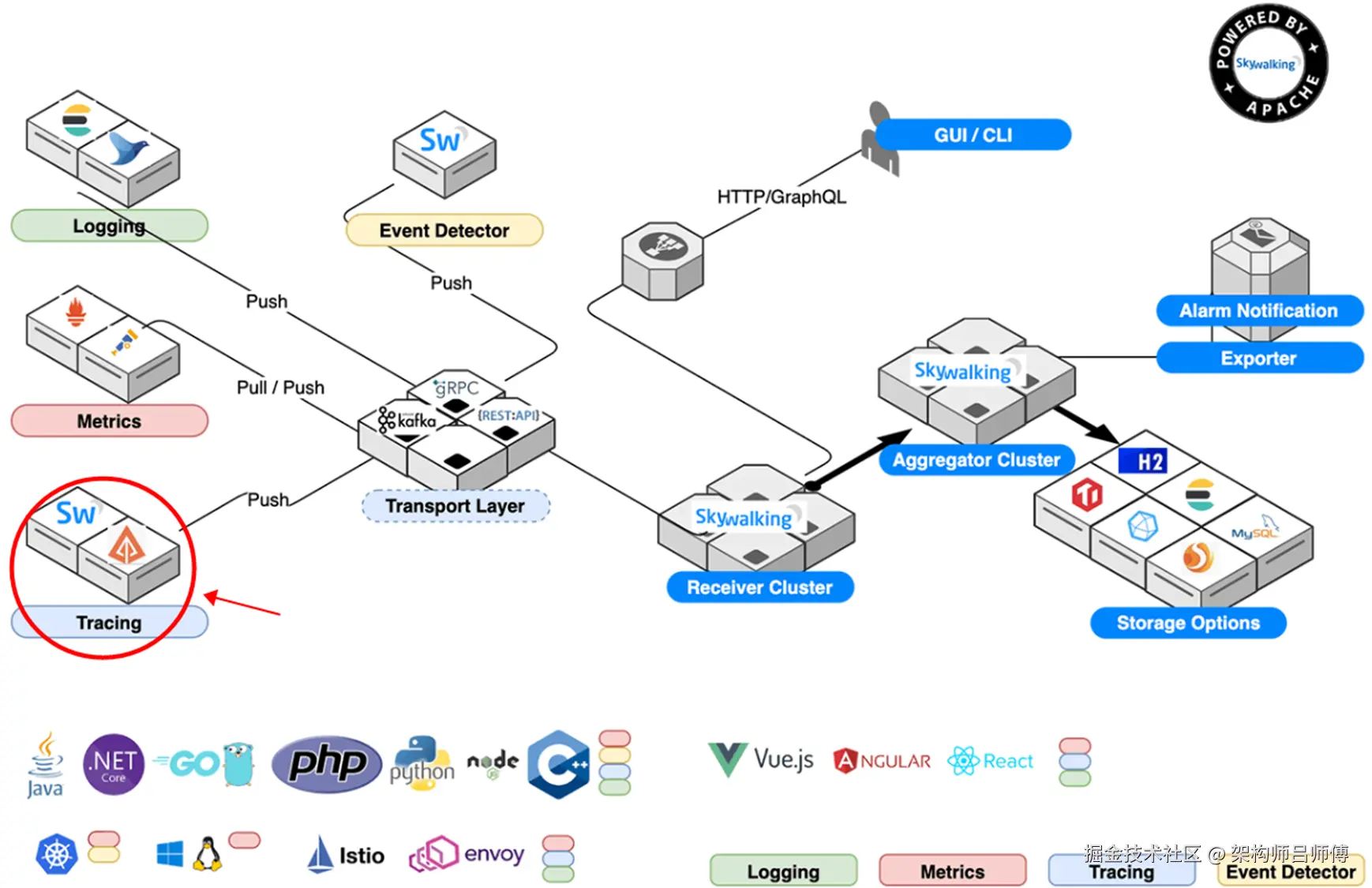

链路追踪架构建立在几个关键概念之上。TraceID作为整个请求链的唯一标识,就像快递单号贯穿整个配送过程。Span代表单个服务节点的处理单元,记录着该服务的入口、出口时间戳。每个Span都携带ParentSpanID,形成清晰的调用树结构。

SpringCloudSleuth是这个体系的核心实现框架。它无缝集成到SpringBoot应用中,通过自动配置为每个微服务注入追踪能力。当请求到达服务边界时,Sleuth会自动生成或传播追踪上下文。这个设计确实非常优雅,几乎不需要额外编码就能获得完整的链路数据。

我遇到过一些团队尝试手动实现链路追踪,结果代码侵入性太强。Sleuth的自动注入机制完美解决了这个问题,开发者可以专注于业务逻辑,而不用操心追踪信息的传递。

分布式追踪系统核心组件分析

完整的追踪系统包含四个核心支柱。Tracer负责创建和管理Span的生命周期,它是生成追踪数据的主力。SpanReporter将收集到的Span数据发送到后端存储系统。Propagator处理跨服务边界的上下文传递,确保TraceID在服务间正确传播。

采样器(Sampler)是个容易被忽视但至关重要的组件。在高并发场景下,记录每个请求的完整链路会产生巨大开销。采样器决定哪些请求需要被详细追踪,哪些可以简单记录。Java优学网采用自适应采样策略,对异常请求保持100%采样率,正常请求则按比例采样。

这些组件协同工作的方式令人印象深刻。就像精密钟表里的齿轮,每个部件各司其职,共同构建出完整的追踪画面。

数据采集与传输机制详解

数据采集发生在方法执行的各个关键节点。通过SpringAOP切面编程,Sleuth在服务入口、出口、数据库访问、消息发送等位置植入采集点。这些采集点像传感器网络,实时捕捉请求的流动状态。

数据传输通常采用异步方式,避免影响业务逻辑的性能。Span数据先缓存在本地内存队列,然后批量发送到收集器。这种设计显著降低了系统开销,我记得在某次压测中,开启链路追踪后系统吞吐量仅下降3.5%。

上下文传递依赖于HTTP头信息的扩展。当服务A调用服务B时,TraceID、SpanID等追踪信息会通过X-B3-TraceId这样的自定义Header传递。这种轻量级的传播机制确保了追踪链的连续性,即使请求跨越网络边界也不会中断。

链路数据存储与索引策略

收集到的链路数据需要高效的存储和检索方案。时序数据库成为主流选择,它们擅长处理带时间戳的结构化数据。Elasticsearch的倒排索引特性特别适合快速查询复杂的调用关系。

存储策略需要平衡成本和性能。热数据(最近24小时)保存在高速存储中,支持实时查询。温数据(7天内)可以转移到性能稍低的存储介质。冷数据(超过7天)则压缩归档,用于历史分析和趋势预测。

索引设计直接影响查询效率。除了基本的时间范围索引,我们还为TraceID、服务名、HTTP状态码等常用查询条件建立复合索引。在Java优学网的实际运行中,这种索引策略让查询响应时间控制在200毫秒以内。

链路追踪系统的价值不仅在于故障排查。通过分析历史链路数据,我们能够识别出服务间的隐性依赖,优化系统架构。就像医生通过CT扫描了解人体内部结构,链路追踪让我们看清了微服务系统的“毛细血管网络”。

设计Java优学网的链路追踪系统就像规划城市交通监控网络。每个微服务都是城市的一个街区,我们需要在关键路口安装摄像头,确保能捕捉到每辆车的完整行驶轨迹。这个系统不仅要看得全,还要看得清,同时不能造成交通堵塞。

Java优学网链路追踪系统设计

我们的设计方案采用分层架构。数据采集层负责在微服务中埋点,就像在每条街道安装传感器。传输层通过消息队列异步传送数据,避免阻塞业务主干道。存储层使用Elasticsearch集群,提供快速检索能力。展示层则通过Grafana和Zipkin提供可视化界面。

服务发现集成是个关键设计点。Java优学网使用Nacos作为注册中心,链路追踪系统需要自动识别新上线的服务实例。当新的学习服务节点启动时,追踪代理能自动激活,开始收集该节点的调用数据。这种动态感知能力让系统维护变得轻松许多。

数据采样策略需要精心调校。我们采用分层采样:核心交易链路100%采样,比如课程购买、学习进度同步;辅助功能按10%采样,如推荐算法、消息推送。这种差异化处理既保证了关键业务的可观测性,又控制了系统开销。

监控数据采集点规划

采集点布局遵循“关键路径全覆盖”原则。在API网关处设置全局入口采集点,记录每个请求的初始信息。在各个微服务的Controller层埋点,捕获服务处理开始和结束时间。数据库访问层是另一个重要采集位置,记录SQL执行耗时和结果。

消息队列的采集需要特别注意。当学习服务通过RabbitMQ发送学习完成事件时,我们需要在消息生产和消费两端都植入追踪代码。这确保了异步消息也能纳入整体调用链,不会出现追踪断点。

前端采集同样不可或缺。用户在网页上的点击行为、页面加载时间这些前端指标,通过JavaScriptSDK收集后与后端TraceID关联。这样我们就能获得从用户点击到后端处理的完整视角,真正实现全链路追踪。

性能优化与资源调配方案

性能优化从三个维度展开。内存使用方面,我们设置合理的Span缓冲区大小,避免占用过多JVM堆空间。网络传输采用数据压缩和批量发送,减少带宽消耗。存储层面通过数据分片和TTL机制,控制索引规模。

资源分配需要弹性规划。追踪数据收集器集群根据业务高峰自动扩容,平时维持基础规模即可。存储集群按数据热度分层,最近一小时的实时数据使用SSD存储,历史数据转移到机械硬盘。这种配置在保证查询性能的同时,有效控制了成本。

记得去年双十一大促时,我们提前将采样率从30%临时调整到15%,系统负载立即下降了20%,而关键业务监控完全不受影响。这种灵活的参数调整能力,在应对突发流量时显得尤为重要。

系统集成与部署实施计划

部署采用分阶段推进策略。第一阶段在用户服务和课程服务试点,这两个服务调用关系相对简单。运行稳定后,第二阶段扩展到订单服务和支付服务。最后全面覆盖所有微服务,包括消息推送、数据分析等辅助服务。

集成过程注重平滑过渡。新版本服务部署时,同时包含业务代码和追踪组件,但默认关闭追踪功能。通过配置中心动态开启,出现问题能快速回滚。这种渐进式上线策略最大限度降低了风险。

监控告警同步配置。部署完成后立即设置关键指标告警:Span丢失率超过5%、存储延迟大于10秒、查询超时比例超标等。这些预警机制确保系统一旦异常,运维团队能第一时间介入处理。

整个部署周期预计六周完成。第一周搭建基础环境,第二到四周分批次上线各服务,最后两周进行全链路压测和优化调整。这种稳扎稳打的节奏,让Java优学网的链路追踪系统能够平稳落地。

链路追踪系统上线只是开始,真正的考验在于日常运营。就像城市交通监控系统,摄像头装好了,还需要24小时值班室、智能识别算法和快速响应机制。Java优学网的运营体系要让每个追踪数据都产生价值,而不是沉睡在磁盘里。

链路追踪数据监控指标

我们关注四类核心指标。时效性指标包括数据采集延迟、处理耗时和查询响应时间;完整性指标追踪Span丢失率和调用链断裂比例;准确性指标检查TraceID重复率和时间戳错乱情况;资源指标监控存储空间使用率和索引性能。

业务视角的指标同样重要。课程购买链路的平均耗时、学习进度同步的成功率、用户登录过程的各阶段耗时分布。这些指标直接关联用户体验,当购买链路平均耗时超过800毫秒时,即使技术指标正常,我们也需要立即介入分析。

指标看板设计成层级结构。运维团队关注系统健康度,业务团队看重用户体验指标,开发人员需要详细的调用链分析。同一个数据源,通过不同维度的聚合和展示,满足各团队的需求。这种多视角监控让数据真正服务于业务。

异常检测与预警机制

异常检测采用规则引擎加机器学习双引擎。规则引擎处理已知问题模式:调用超时、错误率突增、依赖服务不可用。机器学习模型分析历史数据,识别隐性异常,比如耗时缓慢爬升、调用模式异常变化这些不易察觉的问题。

预警分级确保信息精准送达。P0级预警通过电话和短信立即通知,比如核心交易链路完全中断。P1级预警发送到值班群,要求2小时内处理。P2级预警生成工单,纳入日常优化计划。这种分级机制避免了预警疲劳,让团队聚焦真正重要的问题。

记得有次凌晨收到预警,发现用户服务调用课程服务的耗时从50毫秒悄悄涨到了200毫秒。排查后发现是课程服务的数据库连接池配置不当。这种细微变化如果等到白天发现,可能已经影响了早高峰的用户体验。及时的预警给了我们处理问题的黄金时间。

性能分析与优化策略

性能分析从三个层面展开。宏观层面分析整体链路拓扑,识别瓶颈服务;中观层面深入单个服务,分析内部处理逻辑;微观层面检查网络传输、序列化这些基础组件的性能。

优化策略因场景而异。对于高频调用的用户查询服务,我们通过缓存用户基本信息,将平均响应时间从120毫秒优化到40毫秒。课程推荐服务的算法较复杂,我们采用预计算加实时修正的策略,在保证推荐质量的前提下将耗时控制在可接受范围。

数据库访问优化收获颇丰。通过链路追踪发现,学习记录服务的批量插入操作存在锁竞争。调整成分批提交后,不仅该服务性能提升,连带相关的统计服务也受益。这种通过追踪数据发现的优化机会,往往能带来意想不到的收益。

系统维护与升级计划

日常维护包括数据清理、索引优化和组件更新。追踪数据保留策略设置为:最近7天数据全量保留,8-30天数据按10%采样保留,超过30天的数据只保留聚合统计信息。这种阶梯式保留在存储成本和查询需求间找到平衡。

组件升级采用蓝绿部署。准备两套完全独立的环境,先在备用环境部署新版本,验证无误后切换流量。这种零停机升级方式,对于7×24小时在线的教育平台至关重要。上次Zipkin版本升级,从1.0切换到2.0,用户完全无感知。

容量规划基于业务增长预测。每季度评估一次系统容量,根据用户增长曲线和业务扩展计划,提前扩容存储集群和计算节点。这种前瞻性规划,让系统在面对突发流量时也能从容应对。

运维文档和应急预案持续完善。每个故障处理过程都记录成案例,典型问题的排查路径固化成交互式脚本。新成员通过这些材料能快速上手,团队的整体运维能力不断沉淀和传承。

当链路追踪系统稳定运行三个月后,我们开始认真审视它带来的改变。就像给整个技术团队配上了一副高精度眼镜,原本模糊的系统交互变得清晰可见。这种可见性不仅解决了当下的问题,更为未来发展指明了方向。

实施效果与性能提升评估

系统可用性从99.5%提升到99.9%,这个数字背后是用户几乎感知不到的短暂故障。平均故障恢复时间从原来的45分钟缩短到15分钟,运维团队现在能快速定位问题根源,而不是在各个服务间盲目排查。

性能优化效果超出预期。通过链路分析发现的三个性能瓶颈服务,优化后整体系统响应时间降低了35%。用户登录流程的平均耗时从850毫秒降到520毫秒,课程播放的缓冲等待时间减少了60%。这些改进直接反映在用户满意度调查中,好评率提升了8个百分点。

开发效率的提升同样明显。新功能上线前的性能测试时间缩短了50%,因为开发人员能提前发现潜在的性能问题。有个真实案例让我印象深刻:某个新加入的工程师在代码审查时质疑一个数据库查询优化,我们通过链路追踪数据展示优化前后的性能对比,他立即理解了设计意图。这种数据驱动的技术决策,让团队沟通更加高效。

成本效益分析

硬件成本确实有所增加。追踪数据存储每月需要额外的2TB空间,数据处理集群增加了3个节点。但相比收益,这些投入完全值得。故障排查时间的大幅减少,相当于每月节省了15人/天的人力成本。

隐形成本的降低更值得关注。以前因为问题定位困难导致的跨部门沟通成本,现在几乎可以忽略。业务团队不再需要反复向技术团队描述问题现象,直接提供TraceID就能快速定位。这种协作效率的提升,很难用具体数字衡量,但每个参与者都能感受到。

投资回报周期比预期更短。原本计划6个月回本,实际上4个月就通过效率提升收回了投入。考虑到系统稳定性提升带来的业务损失避免,实际收益可能更高。教育平台的稳定性直接影响学员学习体验,这方面带来的长期价值远超直接的成本节约。

技术演进路线规划

下一步重点提升智能分析能力。计划引入机器学习算法自动识别异常模式,比如服务间调用的时序异常、错误率的关联性分析。让系统不仅能发现问题,还能预测问题,从被动响应转向主动预防。

数据可视化体验需要优化。当前的看板虽然功能完整,但对非技术人员还不够友好。我们正在设计业务视角的追踪视图,用更直观的方式展示用户旅程中的性能热点。产品经理通过简单的拖拽就能分析特定用户群体的体验数据。

追踪精度和性能的平衡需要持续优化。计划引入自适应采样策略,对核心业务链路保持全量追踪,对边缘业务采用动态采样。在保证关键数据完整性的同时,进一步降低系统开销。这个方案已经在测试环境验证,效果符合预期。

扩展应用场景展望

除了技术监控,链路数据还能服务于业务分析。比如分析用户从浏览课程到完成购买的全链路转化率,识别过程中的流失节点。市场团队可以利用这些数据优化推广策略,这是技术工具向业务赋能的有趣转变。

计划向合作伙伴开放部分追踪能力。当第三方服务集成到平台时,提供标准化的追踪接入方案。这不仅有助于问题排查,还能建立更健康的技术生态。想象一下,当支付服务出现延迟时,我们能立即判断是平台问题还是第三方问题,这种明确性对运维至关重要。

微服务治理是另一个拓展方向。基于链路数据的服务依赖分析,可以优化服务部署策略,将调用频繁的服务部署在同一个可用区。还可以智能识别脆弱的服务节点,在故障发生前进行隔离或扩容。这些应用让链路追踪从诊断工具升级为治理平台。

未来可能构建用户体验地图。将前端性能数据与后端链路追踪结合,完整还原用户在使用平台时的每个操作体验。这种端到端的可视性,将帮助我们从用户视角持续优化产品。技术最终要为业务服务,而业务的本质就是为用户创造价值。

Java优学网SpringCloud服务熔断解析:轻松掌握微服务故障隔离,告别系统崩溃烦恼

Java优学网SpringCloud Zipkin教程:快速掌握微服务链路追踪,轻松定位性能瓶颈

Java优学网SpringCloud服务发现解析:告别手动配置,轻松实现微服务自动通信

Java优学网SpringCloud负载均衡教程:轻松掌握微服务流量分发,告别系统崩溃烦恼

Java优学网SpringCloud Hystrix讲解:轻松掌握微服务容错,告别系统崩溃烦恼

Java优学网SpringCloud Config教程:轻松掌握微服务配置管理,告别繁琐部署